为何 SlowFast-LLaVA-1.5 可能是长视频理解的突破口——且无需高昂的计算成本

AI 视频处理的真正瓶颈?不仅仅是算力,而是 Tokens

长视频内容正在爆发式增长。从监控录像到教育讲座,提取多分钟甚至多小时视频中的洞察变得前所未有地重要。但对于 AI 来说,理解视频中的长期时序上下文,不仅仅是投入更多帧或微调更大的模型。

真正的挑战是什么?Token 效率。

目前大多数视频大型语言模型(Video LLM)都难以扩展。它们处理大量数据,但会消耗大量算力和内存,这使得它们在移动、边缘甚至许多企业部署中都不切实际。

这就是 SlowFast-LLaVA-1.5 出现的原因。它是一种 Token 高效、可复现的长视频理解解决方案,它结合了一种新颖的双流处理方法和一个精简的训练流程——即使使用较小的模型(低至 10 亿参数)也能提供最先进的性能。

对于押注于可扩展 AI 的企业,以及寻求边缘可部署 AI 解决方案的投资者来说,该模型代表着一项有意义的技术和战略转变。

改变游戏规则的双流架构

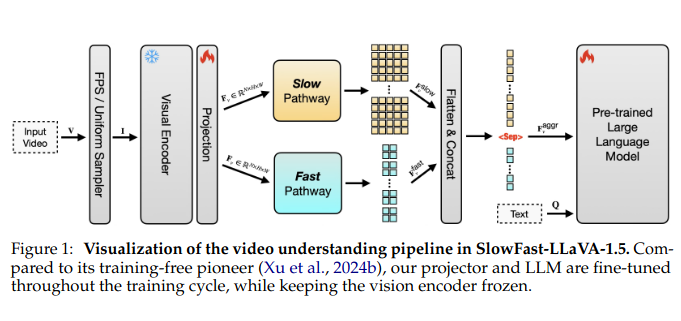

SlowFast-LLaVA-1.5 的核心是一个巧妙的架构调整,它借鉴并改编自之前在视频识别方面的工作:一个 SlowFast 机制。它是这样运作的:

- Slow stream(慢速流) 以更高的分辨率处理较少的帧,从选择的关键帧中捕获丰富的空间细节。

- Fast stream(快速流) 处理更多的帧,但粒度较低,侧重于运动和时间流。

通过结合这些路径并聚合它们的输出,该模型可以捕获每一帧中发生的事情以及场景如何随时间演变——而不会淹没在 Tokens 中。

这是对整体式视频 Transformer 的一种转变,后者难以平衡空间准确性和时间范围。结果呢?与其他领先模型相比,SlowFast-LLaVA-1.5 使用 仅仅 65% 的 Tokens 就能处理近两倍的帧数。

更精简的训练,更广泛的应用

训练大型视频模型是出了名的麻烦——通常涉及专有数据集、多阶段流程和资源密集型调整。SlowFast-LLaVA-1.5 的作者采取了一种更务实的路线:

- 第一阶段 – 仅图像微调:首先在公开的图像数据集上训练模型,以建立视觉基础和一般推理能力。

- 第二阶段 – 联合视频-图像训练:然后将它暴露于一组精心挑选的视频和图像数据,使模型能够学习空间和时间动态。

数据集是开源的,并且该方法是可复现的——这两个属性在最近的 LLM 版本中经常缺失。这种对可访问性的强调不仅仅是学术性的;它降低了希望集成高级视频 AI 的小型公司或初创企业的准入门槛。

支持该主张的基准

性能指标在多个备受瞩目的基准测试中进行了测试,包括:

- LongVideoBench:7B 模型达到 62.5%

- MLVU(多模态长视频理解):相同模型达到 71.5%

值得注意的是,即使是 1B 和 3B 参数模型 也提供了具有竞争力的结果,证明大小并不总是决定因素。这对于探索 移动或边缘部署 的公司来说尤其具有吸引力。

此外,由于其联合训练策略,该模型没有牺牲图像推理能力。它可以与专用图像语言模型相媲美——对于统一的多模态处理来说,这是一个明显的胜利。

效率而不妥协

从原始数据来看,效率的提高是显而易见的:

- 处理的帧数最多可达 2 倍

- 使用的 Tokens 比同类模型少约 35%

- 在保持或超过性能水平的同时,显着降低了计算成本

这种 准确性和效率 的平衡解锁了更广泛的用例——从智能相机和物联网监控系统到应用内视频助手或企业知识挖掘工具。

对于投资者来说,这意味着更强的投资回报率和更低的产品化壁垒。

跨行业的战略价值

企业 AI 集成:凭借其紧凑的尺寸和高效的架构,SlowFast-LLaVA-1.5 可以部署在带宽、计算和延迟是关键限制的环境中——例如现场监控、零售中的客户行为分析或现场机械诊断。

媒体和流媒体平台:以较低的成本实现长视频的自动摘要、搜索索引和内容审核。

辅助技术和可访问性:当处理不需要云规模的基础设施时,实时解释视频以帮助视力障碍用户变得更加可行。

安全和国防:无人机和设备上的监控系统可以从较小的模型中受益匪浅,这些模型可以分析实时视频流,而无需上传千兆字节的视频。

局限性和开放机会

作者承认两个主要局限性:

- 帧采样限制:虽然帧采样对于大多数用例是基于 FPS 的,但当视频长度超过设定的帧阈值时,该模型默认使用均匀采样——可能会错过超长内容中的关键时刻。

- 冻结的视觉编码器:为了保持效率,视觉编码器在训练期间保持冻结。虽然有效,但微调该模块可能会释放更高的性能,但计算成本也会更高。

这些限制指出了未来版本的逻辑后续步骤:自适应采样技术,选择性视觉模块调整,以及集成 内存高效架构。

这对行业有何重要意义

视觉到语言的范式正在快速发展。到目前为止,视频 AI 的大多数突破都依赖于蛮力——更大的模型、更大的数据集、更多的 Tokens。

SlowFast-LLaVA-1.5 提供了一种 战略上更精简的方法。它不仅仅是一个新模型——它是 高效 AI 如何在不使基础设施过载的情况下跨行业扩展视频理解 的蓝图。

它证明了 Token 效率可以与参数规模一样强大——研究界和商业生态系统都需要认真对待这一信息。

给投资者和建设者的最终启示

如果您的路线图涉及智能视频处理——无论是用于消费技术、工业应用还是实时分析——SlowFast-LLaVA-1.5 表明 高性能 AI 不一定意味着高成本 AI。

对于风险投资而言,这为支持以前缺乏资源来训练或运行大型视频模型的初创企业打开了大门。对于企业建设者来说,这是一个部署具有竞争力的视频 AI 而无需重建整个基础设施堆栈的机会。